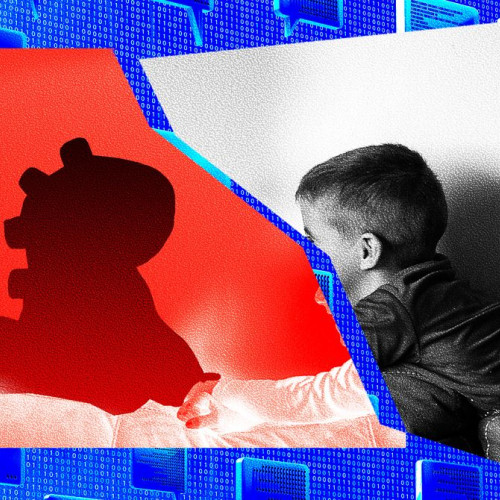

Google anunță că atacatorii au folosit peste 100.000 de solicitări pentru a încerca să cloneze chatbotul AI Gemini

Google afirmă că chatbotul său artificial de inteligență, Gemini, a fost supus unor atacuri motivate comercial, actorii care stau în spatele acestora încercând să-l cloneze prin solicitări repetate, uneori cu mii de întrebări diferite. Conform unui raport publicat joi, Google spune că a fost tot mai des vizat de „atacuri de distilare”, întrebări repetate menite să dezvăluie funcționarea internă a chatbotului, potrivit nbcnews.com.

👉 Descrierea metodei și scopului atacurilor asupra modelului Gemini

Google a descris activitatea drept „extracție de model”, în care clonele potențiale probează sistemul pentru a descoperi tiparele și logica care îl fac să funcționeze. Atacatorii par să vrea să folosească informațiile pentru a construi sau îmbunătăți propriile lor soluții AI, a indicat compania. Aceasta consideră că autorii sunt în principal companii private sau cercetători care caută un avantaj competitiv. Un purtător de cuvânt a declarat pentru NBC News că Google crede că atacurile au venit din întreaga lume, dar nu a oferit detalii suplimentare despre suspecți.

👉 Riscurile și vulnerabilitățile asociate atacurilor asupra AI

Scopul atacurilor asupra lui Gemini sugerează că acestea ar putea deveni comune și pentru instrumentele de AI personalizate ale companiilor mai mici, a spus John Hultquist, analistul-șef al Grupului de Inteligență în Fața Amenințărilor de la Google. „Vom fi canar în mina de cărbune pentru mult mai multe incidente”, a declarat Hultquist, refuzând să numească suspecți. Compania consideră distilarea ca fiind furt de proprietate intelectuală.

Companiile tehnologice au cheltuit miliarde de dolari într-o cursă pentru a dezvolta chatboturi AI sau modele de limbaj mari (LLM), considerând că funcționarea internă a celor mai bune modele ale lor este o informație extrem de valoroasă și protejată. Deși au mecanisme pentru a încerca să identifice atacurile de distilare și să blocheze persoanele din spatele lor, LLM-urile majore sunt inerent vulnerabile la distilare, deoarece sunt accesibile oricui pe internet.

OpenAI, compania din spatele ChatGPT, a acuzat rivalul său chinez DeepSeek anul trecut de desfășurarea atacurilor de distilare pentru a îmbunătăți modelele sale. Multe dintre atacuri au fost concepute pentru a scoate la iveală algoritmii care ajută Gemini să „raționeze” sau să decidă cum să proceseze informațiile, a declarat Google. Hultquist a afirmat că, pe măsură ce tot mai multe companii își proiectează proprii LLM-i personalizați antrenați pe date potențial sensibile, devin vulnerabile la atacuri similare. „Să spunem că LLM-ul dumneavoastră a fost antrenat pe 100 de ani de gândire secretă a modului în care faceți comerț. Teoretic, ați putea distila o parte din aceasta”, a spus el.